Modelos de predicción que anticipan tendencias informativas, redes neuronales profundas que optimizan procesos automatizados o técnicas complejas que hacen posible chatbots más inteligentes son elementos de la inteligencia artificial (IA) cada vez más presentes en las salas de redacción.

No obstante, todavía existen muchos medios y periodistas que no están del todo familiarizados con conceptos como estos, algunos de los cuales están redefiniendo cómo se produce y consume el periodismo.

En una entrega anterior, LatAM Journalism Review (LJR) exploró la definición de conceptos básicos de la IA y su aplicación en la sala de redacción. En esta ocasión, profundizamos con 10 términos avanzados de IA, como minería de datos, análisis predictivo y búsqueda semántica. También presentamos ejemplos de cómo estos elementos están ayudando a los medios de noticias a mejorar aspectos de su trabajo como la precisión de las investigaciones, la relación con las audiencias y la eficiencia en la generación de noticias.

Una entidad se refiere a una unidad de información que puede ser reconocida, procesada y utilizada por los sistemas de IA. Las entidades pueden representar diversos elementos, como objetos, conceptos, nombres, eventos, cantidades o relaciones.

Las entidades son esenciales para la interpretación y comprensión de los datos en los algoritmos de IA, ya que funcionan como bloques de construcción para que los sistemas procesen y analicen la información con eficacia. Al reconocer y clasificar entidades, los sistemas de IA pueden transformar datos no estructurados en información estructurada, facilitando tareas como el análisis de datos y la recuperación de información.

Ejemplo en periodismo: TimeLark es una herramienta de investigación periodística desarrollada en 2023 por periodistas y técnicos de la BBC, el Proyecto de Información sobre Delincuencia Organizada y Corrupción (OCCRP, por sus siglas en inglés) y la agencia Reuters. La herramienta sirve para analizar grandes volúmenes de información y descubrir conexiones ocultas entre los elementos de un evento noticioso.

TimeLark usa aprendizaje automático para extraer entidades de artículos de noticias no estructurados, las conexiones entre estas y su relación en el tiempo. La información extraída es luego plasmada en gráficas para facilitar su análisis. La herramienta fue probada con más de 30 mil artículos de BBC y Reuters sobre la guerra en Ucrania, donde las entidades extraídas fueron líderes políticos, países y organismos internacionales involucrados, así como personajes alrededor de estos.

En el contexto de la IA, las alucinaciones son un fenómeno en el que un modelo de IA –especialmente aquellos basados en modelos de lenguaje de gran tamaño (LLM, por sus siglas en inglés)– genera respuestas o resultados que son incorrectos o incoherentes.

Las alucinaciones pueden deberse a diversas causas, entre ellas a que el modelo de IA "percibe" patrones que no existen, o bien a que el modelo no cuenta con suficiente información relevante para generar una respuesta adecuada e intenta llenar ese vacío con información irrelevante.

Ejemplo en periodismo: En 2023, periodistas de The New York Times pusieron a prueba la precisión de ChatGPT con preguntas como cuándo el diario había publicado el primer artículo sobre IA.

La plataforma respondió que había sido el artículo “Las máquinas serán capaces de aprender y resolver problemas, predicen los científicos”, publicado supuestamente el 10 de julio de 1956 como parte de la cobertura de una conferencia seminal en el Dartmouth College, en New Hampshire.

The New York Times reportó que la conferencia había sido real, pero el artículo nunca había existido.

Expertos han advertido que alucinaciones como esa muestran que el uso de la IA generativa en tareas automatizadas de periodismo pueden resultar en la publicación de información falsa o errónea que parece verídica.

Text-to-speech es una tecnología dentro del campo de la IA que permite generar un audio de voz humana sintética a partir de un texto escrito. Esta conversión se realiza mediante algoritmos de procesamiento de lenguaje natural (PLN) para interpretar el texto, junto con modelos avanzados de síntesis de voz.

Entre las técnicas más utilizadas están las redes neuronales profundas, como Tacotron y WaveNet, que son capaces de generar audio fluido y de apariencia natural. Otras técnicas más tradicionales, pero de cada vez menor uso, son la concatenación de fragmentos de voz pregrabados o modelos matemáticos que simulan las propiedades acústicas del habla.

Ejemplo en periodismo: Illariy es el nombre de un avatar creado con IA para presentar las noticias en idioma quechua en un noticiario universitario en Perú.

Para hacer que Illariy hablara quechua fluidamente, sus creadores usaron D-ID, una plataforma capaz de hacer que imágenes “hablen” a partir de tecnologías text-to-speech. Dado que el quechua no está entre las lenguas soportadas por D-ID, los creadores de Illariy le proporcionaron a la plataforma texto con vocablos fonéticos en español que una vez leídos por el sistema, emulaba palabras en quechua.

Reconocimiento Óptico de Caracteres (OCR, por sus siglas en inglés) es una tecnología que utiliza algoritmos especializados para convertir documentos con texto en texto editable. Esta tecnología permite la digitalización de documentos impresos y permite que los sistemas informáticos puedan leer y procesar el texto contenido en imágenes o archivos escaneados.

Los sistemas detrás del OCR pueden ser algoritmos de visión computarizada, de reconocimiento de patrones o de aprendizaje profundo (Deep Learning OCR). Estos últimos están basados comúnmente en redes neuronales y son especialmente útiles en el reconocimiento de textos manuscritos.

Ejemplo en periodismo: El Consorcio Internacional de Periodistas de Investigación (ICIJ) creó Datashare, una herramienta de código abierto que permite cargar enormes cantidades de datos y buscar información. La herramienta incluye tecnología de OCR que permite digitalizar texto de documentos escaneados y manuscritos.

Uno de los usos más destacados de Datashare fue en la mega investigación transfronteriza y colaborativa “Pandora Papers”, en la que la herramienta ayudó a organizar y analizar 11.9 millones de documentos filtrados. La función de OCR permitió a los periodistas detectar automáticamente nombres y organizaciones de los documentos, así como extraer entidades a bases de datos.

El data mining o minería de datos es un proceso analítico que utiliza técnicas de aprendizaje automático, estadística y sistemas de bases de datos para explorar grandes conjuntos de datos y descubrir patrones, tendencias y relaciones significativas que no son inmediatamente visibles.

Ejemplo en periodismo: Para las investigaciones periodísticas basadas en filtraciones de millones de documentos es necesario el análisis de grandes cantidades de datos. Periodistas convocados por el ICIJ para mega investigaciones como los Panama Papers, los Paradise Papers o los Pandora Papers han recurrido a RapidMiner, una herramienta que utiliza algoritmos de minería de datos.

RapidMiner ayuda a procesar el texto y los metadatos de los documentos filtrados y crear clusters basados en palabras y frases comunes, de modo que la consulta de archivos sea más ágil.

El análisis predictivo en IA es un enfoque basado en modelos estadísticos, algoritmos de aprendizaje automático y datos históricos para prever eventos futuros. Su objetivo es identificar patrones y tendencias en grandes volúmenes de datos para optimizar la toma de decisiones.

Los algoritmos de análisis predictivo procesan datos históricos mediante un flujo de trabajo que incluye la recolección, limpieza y estructuración de la información. Luego, el sistema selecciona las variables más relevantes y aplica modelos matemáticos como regresión, árboles de decisión o redes neuronales para generar predicciones basadas en probabilidades y patrones detectados en los datos.

Ejemplo en periodismo: The New York Times ha utilizado algoritmos de análisis predictivo para algunas de sus estrategias comerciales y editoriales. El diario usó dicha técnica para analizar cómo los lectores se convierten en suscriptores, y cómo se podía influir para aumentar esas conversiones.

El análisis predictivo también ayudó al medio en comprender los temas que generan más participación de los lectores, de modo que los equipos de marketing pudieran saber qué tipos de artículos promover en redes sociales.

La búsqueda semántica es una técnica avanzada de búsqueda de datos que se enfoca en comprender el significado y la intención detrás de una consulta, en lugar de simplemente buscar coincidencias literales de palabras clave.

Esta tecnología utiliza el PLN y el aprendizaje automático para analizar el lenguaje natural y captar matices como el contexto y la intención del usuario, lo que da como resultado una búsqueda más precisa y relevante.

Ejemplo en periodismo: AskFT es una herramienta de IA generativa desarrollada por el periódico británico Financial Times en 2024, inicialmente solo disponible para sus clientes corporativos. La herramienta utiliza un LLM que mediante la búsqueda semántica encuentra artículos relevantes a la pregunta del usuario.

Para ello, los artículos son previamente deconstruidos en segmentos y vectorizados. La herramienta resume los artículos resultantes de la búsqueda en una respuesta generada por el LLM, que incluye citas de los artículos.

El reconocimiento de entidades nombradas (Named Entity Recognition, NER) es una subárea del PLN que se enfoca en identificar y clasificar entidades nombradas en textos no estructurados. Estas entidades pueden incluir nombres de personas, organizaciones, lugares, cantidades, valores monetarios, porcentajes, etcétera.

El NER utiliza algoritmos, modelos estadísticos y aprendizaje profundo para detectar entidades y clasificarlas, lo que facilita el análisis y procesamiento de textos no estructurados.

Ejemplo en periodismo: Periodistas de La Nación (Argentina), Ojo Público (Perú), CLIP (Costa Rica) y MuckRock (Estados Unidos) desarrollaron en 2021 DockIns, una herramienta que, mediante técnicas de aprendizaje automático y PLN analiza y clasifica documentos de contenido no estructurado, extrae información de estos documentos e identifica temáticas y entidades.

Para perfeccionar la herramienta, el equipo probó varios modelos NER, entre ellos SpaCy y DocumentCloud, con más de 10 mil documentos con datos no estructurados de licitaciones, contratos y compras del Ministerio de Seguridad de Argentina.

La generación aumentada por recuperación (Retrieval-Augmented Generation, RAG) es una técnica de IA que combina la generación de lenguaje natural con la recuperación de información de fuentes distintas a los datos usados para el entrenamiento del modelo. Esto ayuda a mejorar la precisión de las respuestas generadas y evitar las “alucinaciones”.

Un sistema RAG, compuesto por un LLM y un sistema de recuperación de información, puede incluso conectarse a fuentes de información en tiempo real o de frecuente actualización, como redes sociales o sitios de noticias, para generar respuestas con datos al día.

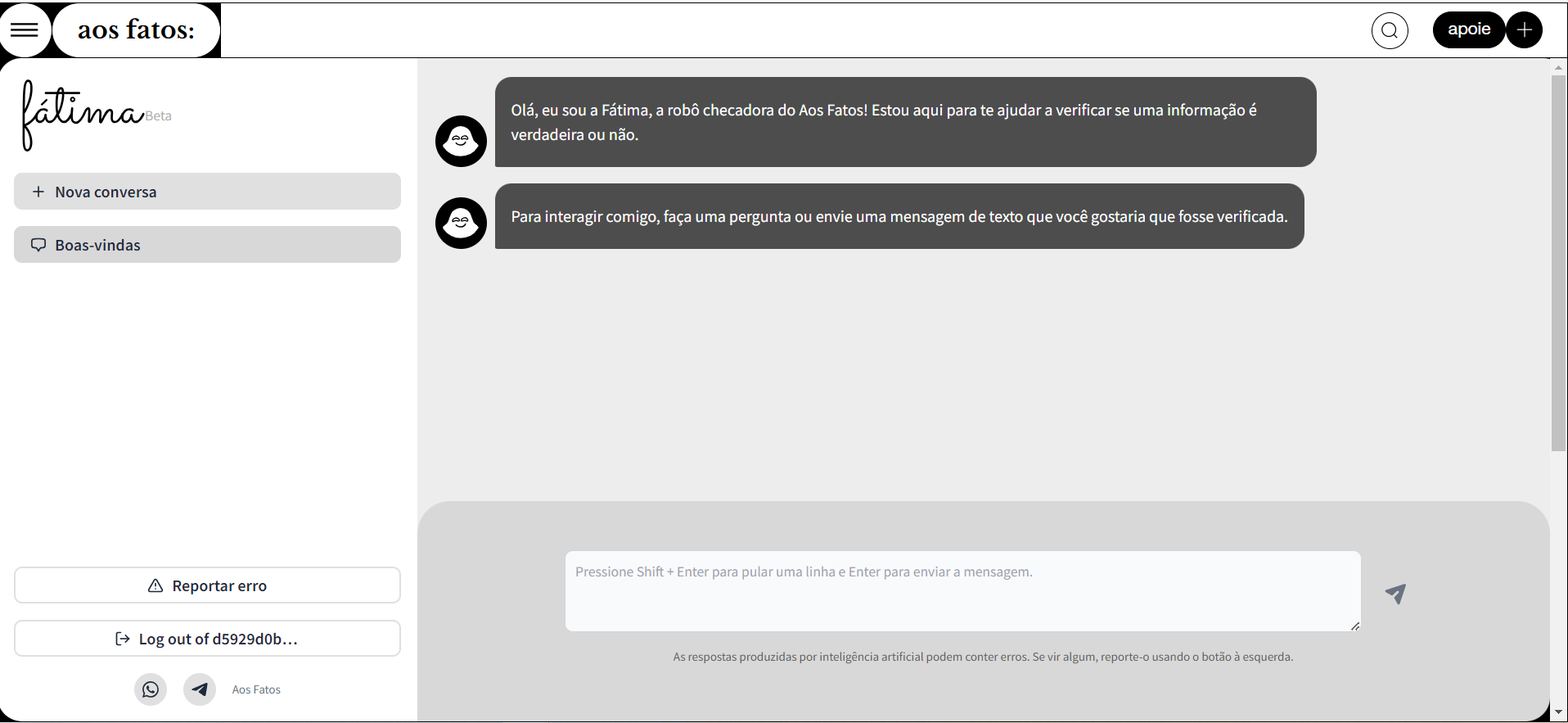

Ejemplo en periodismo: Para evitar al máximo las “alucinaciones”, FátimaGPT, el chatbot verificador del medio brasileño especializado en fact-checking Aos Fatos, utiliza un modelo RAG. Este modelo RAG vincula el modelo de aprendizaje de lenguaje del chatbot a una base de datos específica y fiable de la que extrae la información que necesita para generar respuestas.

Esa base de datos está conformada por todo el material periodístico y de verificación que ha producido Aos Fatos.

El prompt design o diseño de instrucciones es el proceso de crear y optimizar las instrucciones dadas a los modelos de IA para que éstos generen respuestas precisas, coherentes y adecuadas a lo que el usuario necesita.

Un buen diseño de prompts no solo mejora la precisión de las respuestas de LLM como ChatGPT o Gemini, sino que también permite aprovechar al máximo las capacidades de estas herramientas.

El diseño de prompts incluye la utilización de distintas técnicas, dependiendo de la situación y el contexto del usuario. Algunas de ellas son el uso de ejemplos, técnicas de prueba y error, asignación de roles y delimitación del alcance, entre otras.

Ejemplo en periodismo: Joe Amditis, periodista y profesor en la Montclair State University de Nueva Jersey, publicó en 2023 el “Manual de prompts para principiantes: ChatGPT para editores de noticias locales”, en el que enseña cómo los periodistas pueden diseñar prompts eficaces y cómo calibrarlos para casos de uso específicos en su redacción.

El documento presenta las partes que integran un buen prompt, discute la importancia de la claridad, la especificidad y la contextualización en el diseño de éste y ofrece varias técnicas que los periodistas pueden utilizar. También aborda la importancia de la iteración y la experimentación en el diseño de prompts para mejorar la precisión y la relevancia de las respuestas.