Un video en el que se escucha la voz del periodista mexicano Carlos Loret de Mola cuestionando un proyecto de parque interurbano en el estado de Querétaro circuló en redes sociales a finales de 2023. El video da la impresión de ser parte de un reportaje como los que el periodista presenta en su programa “Loret” de la cadena digital Latinus.

Sin embargo, a los pocos días el propio Loret de Mola en sus redes sociales desmintió la autenticidad del video y negó que se tratara de su voz. Algunos medios de comunicación reportaron que se trataba de un video generado con inteligencia artificial (IA) y apuntaban a que pudo haber sido parte de una estrategia de desprestigio en contra del presidente municipal de la ciudad de Querétaro, quien presentó el proyecto de parque del que se habla en el video.

Similar al caso de Loret de Mola, en México han circulado en meses recientes videos que usan la voz de personalidades como entonces la candidata a la presidencia por el partido oficialista Claudia Sheinbaum, el magnate de las telecomunicaciones Carlos Slim o el futbolista argentino Lionel Messi para promover productos o aplicaciones que prometen generar ingresos de forma fácil.

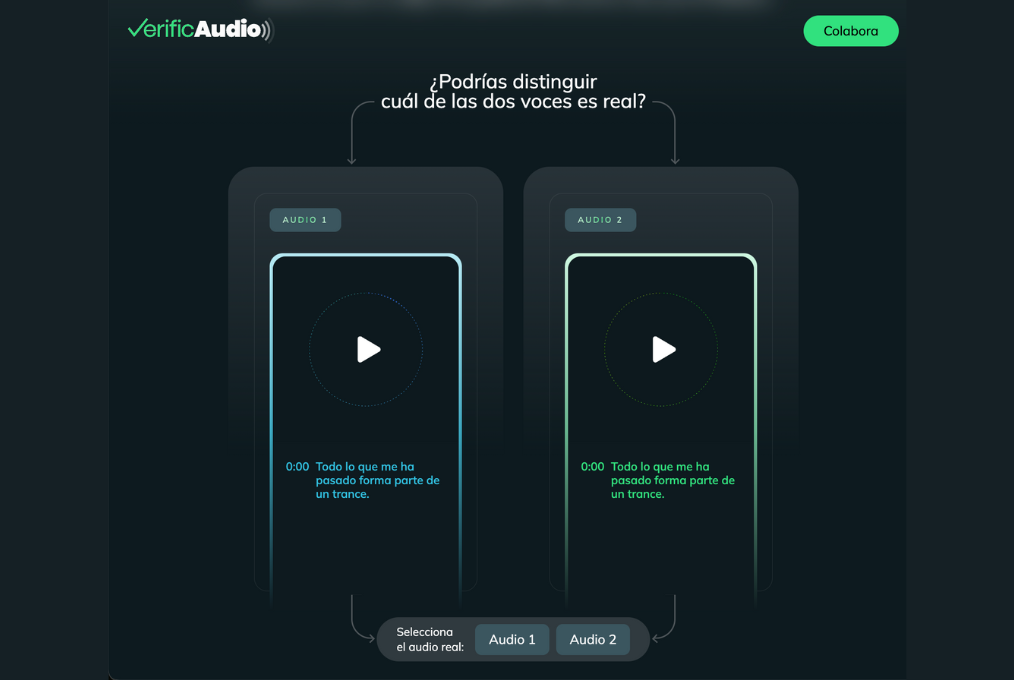

VerificAudio consiste de dos modelos de Procesamiento de Lenguaje Natural (PLN), uno identificador y otro comparativo. (Foto: Captura de pantalla del sitio web de VerificAudio)

Carlos Urdiales, director de la estación W Radio en México, en la que Loret de Mola encabeza el programa de noticias del mediodía, considera que la tecnología que hizo posible el video con la voz clonada del periodista podría ser sumamente peligrosa este año en México, considerando que el país recién celebró la elección más grande de su historia.

Por ello, dijo, su estación abrazó desde un inicio el proyecto VerificAudio, una herramienta de IA que busca combatir la desinformación en contenidos sonoros. La herramienta fue desarrollada por iniciativa del grupo español de medios PRISA, del cual forma parte W Radio y otras casi 30 marcas de radiodifusoras en España y América Latina.

“La inteligencia artificial como herramienta sabemos que nos plantea desafíos como periodistas, por los deep fakes, por el año mega electoral a nivel global”, dijo Urdiales a LatAm Journalism Review (LJR). “Tener a disposición el uso correcto de la inteligencia artificial [...] adquiere un valor enorme, sobre todo en términos de nuestra responsabilidad ante nuestros oyentes”.

VerificAudio fue presentada en marzo de 2024, tras lo cual pasó un periodo de prueba de casi tres meses, durante los cuales se continuó entrenando los modelos de IA que lo conforman y se capacitó a los equipos de las estaciones de Cadena SER (España), ADN (Chile), Caracol (Colombia) y W Radio (México), de PRISA, con miras a integrar la herramienta en sus protocolos de verificación de hechos. Aunque hasta el momento VerificAudio ha estado disponible únicamente para las estaciones de PRISA, Ana Ormaechea, directora de producto digital de PRISA Radio, dijo que la compañía ya contempla abrirla a otros periodistas.

“La herramienta ya está en un nivel de madurez alto y estamos dispuestos a abrir un escenario de colaboración con otros medios que estén interesados”, dijo Ormaechea a LJR.

El rápido perfeccionamiento de las técnicas de clonación de voz con el uso de IA y el mal uso de éstas son dos de los cambios más preocupantes que está viviendo el ecosistema de medios en los países de habla hispana actualmente, dijo Ormaechea.

Por ello, para PRISA Radio, VerificAudio es una herramienta para combatir los cada vez más sofisticados deep fakes en audio y con ello salvaguardar la confianza que sus estaciones han logrado consolidar entre sus oyentes a lo largo de varias décadas.

“Este año vimos que votaba más de la mitad de la población [global]. Tenemos votaciones importantes en México, en Estados Unidos, además aquí [en España] tenemos las europeas. Sabemos que siempre que hay un periodo electoral importante se generan, desgraciadamente, situaciones de desinformación”, dijo Ormaechea. “Nos daba mucho miedo que con este avance de la tecnología y de la aplicación de la IA a la clonación de voces, y esta situación electoral se generara durante 2024 un incremento grande de desinformación a través del audio”.

PRISA encargó el desarrollo de VerificAudio a la empresa española de tecnología Minsait, que trabajó en ella durante cerca de un año. El proyecto contó con el apoyo de Google News Initiative, tanto en el desarrollo de la idea como en los fondos para su ejecución.

Google News Initiative decidió apoyar el proyecto porque éste se alinea con dos de los pilares que la compañía tecnológica busca impulsar actualmente: el desarrollo de la IA y el combate a la desinformación.

“VerificAudio se suma a un grupo de herramientas clave que pueden usar los periodistas a la hora de verificar información. Este es un claro ejemplo de cómo la Inteligencia Artificial puede ayudar al periodismo y a la información de manera correcta”, dijo a LJR Haydée Bagú, News Partner Manager de Google Latinoamérica.

VerificAudio consiste de dos modelos de Procesamiento de Lenguaje Natural (PLN), uno identificador y otro comparativo. El identificador consiste en un modelo de machine learning que compara el material sospechoso con audios de los archivos de las estaciones de PRISA con base en un conjunto de indicadores predeterminados, y entrega un porcentaje de autenticidad, explicó Ormaechea.

La voz de la hoy presidenta electa de México, Claudia Sheinbaum, fue manipulada en videos durante su campaña electoral. (Foto: Captura de pantalla del Facebook del partido Morena)

El modelo comparativo consiste de un modelo de código abierto conocido como “transformer” de redes neuronales, el cual fue sometido a un proceso de fine-tuning para adaptarlo al español. De acuerdo con Google, un “transformer” es un modelo de PLN que transforma una secuencia de entrada en una secuencia de salida, para lo cual “aprende” elementos de contexto y las relaciones entre los componentes de dichas secuencias.

El modelo “transformer” de VerificAudio convierte cada pieza de audio en una serie de vectores que representan las particularidades de la voz, como timbre, entonación y patrones del habla, y luego los compara con los de los audios preexistentes para detectar indicios de clonación.

Ese protocolo de doble comprobación busca aumentar la precisión de la herramienta y minimizar el número de resultados falsos. Ambos componentes han sido entrenados por PRISA con audios de voces reales y voces clonadas, dijo Ormaechea, quien agregó que la prioridad de la compañía es seguir entrenando VerificAudio con el apoyo de las estaciones filiales en España y América Latina, para que la herramienta sea capaz de reconocer y analizar voces con diferentes acentos del español.

“Los malos van muy rápido. Cada día nos despertamos con un avance nuevo. Necesitamos que en el día a día sigamos entrenando a los modelos para que puedan estar al nivel de la eficacia que tiene esa desinformación. Esos deep fakes cada vez vemos que son de mejor calidad, que los están distribuyendo muy bien”, dijo Ormaechea.

Tras su lanzamiento en marzo, PRISA lanzó un sitio web con una interfaz abierta de VerificAudio para presentar la herramienta al público en general y para que usuarios pudieran enviar audios sospechosos para ser analizados. Mientras tanto, la herramienta fue sometida a un proceso de entrenamiento de sus modelos para afinar sus resultados y “acostumbrarla” a los acentos de cada país en los que se ubican PRISA, antes de ponerla en uso en sus redacciones.

Ormaechea dijo que la compañía creó un comité verificador transversal, integrado por miembros del staff de noticias de cada una de las estaciones de PRISA. Dicho comité se encarga de analizar los audios enviados por el público a través del sitio web de VerificAudio y además utiliza esos audios para continuar con el entrenamiento de los modelos.

Esos miembros del staff son los que eventualmente estarán a cargo de la herramienta en cada estación. En W Radio fueron designados dos miembros de la redacción, uno del equipo digital y otro de la producción de noticias, dijo a LJR Emmanuel Manzano, director de medios digitales de W Radio.

“Después de esa capacitación o curva de aprendizaje por parte de la redacción, ya en próximas semanas comenzarán a usarla de manera práctica”, dijo Manzano, quien esperaba que los primeros días de junio iniciaría el uso de la herramienta en la estación mexicana.

El objetivo de VerificAudio no es reemplazar los protocolos de verificación de las salas de redacción, ni avalar o desmentir contenido de audio. La intención de PRISA con la herramienta es que ésta proporcione una evaluación de las características del audio y un porcentaje de fiabilidad para que los periodistas tomen una decisión final bajo los estándares de fact-checking de sus medios.

“Por eso existe este comité [en cada estación], porque no solamente se trata de meterlo [el audio sospechoso] a la herramienta y que te haga una validación”, dijo Manzano. “También hay que darle contexto al mismo audio, desde dónde provino, qué lo generó, la validez de la información que se está escuchando en el audio… Hay mucho más que solo meterlo a la herramienta, hay todo un proceso”.

El periodista Carlos Loret de Mola es otra víctima de la clonación de voz. La estación en la que se transmite su noticiario, W Radio, es una de las que participan el proyecto de VerificAudio. (Foto: Captura de pantalla del Facebook de W Radio)

Urdiales agregó que en W Radio no esperan que VerificAudio reemplace a los periodistas en labores de verificación de contenido y dijo que el análisis de contexto que hacen los periodistas es fundamental para desmentir los deep fakes.

“VerificAudio da como esta posibilidad de meter, de procesar y de tener una data más firme y más certeza de ese rigor de saber que sí es muy probable que [un contenido] sea auténtico o muy probable que no lo sea, y tomar decisiones a partir de eso”, dijo Urdiales. “Pero al final de este proceso de construcción de contenido periodístico informativo, siguen teniendo un gran peso las instituciones y las estructuras de los profesionales de una mesa de redacción”.

Para el periodista, la herramienta llegó en un momento muy oportuno a su redacción, unos meses antes de las elecciones presidenciales que se llevaron a cabo el 2 de junio en México. Sin embargo, dijo que, si bien durante el periodo de campañas electorales en ese país hubo algunos casos de audios con voces supuestamente clonadas de miembros de la política, éstos fueron relativamente sencillos de desacreditar y no causaron mayor efecto en el curso del proceso electoral.

Ormaechea dijo que hasta inicios de junio, la interfaz pública de VerificAudio había recibido deep fakes procedentes de Venezuela y México, en su mayoría, pero también de otros países como Estados Unidos o Cuba.

“Nuestro objetivo fue hacerlo [VerificAudio] muy rápido para ponerlo en marcha internamente y poder seguir haciendo pruebas y mejorándolo antes de que llegaran las elecciones en México”, dijo Ormaechea. “Para nosotros, las elecciones en México, y yo creo que las de Estados Unidos –porque también habrá deep fakes en español en las de Estados Unidos- serían el foco”.

No obstante, para Urdiales es más preocupante lo que viene en el futuro cercano en cuanto al nivel de sofisticación de los deep fakes y el impacto que puedan tener en la credibilidad de los medios de noticias.

“Cada vez te das cuenta que hay audios que dices ‘madre mía, si a mí ya me está haciendo dudar, quiere decir que un público general se lo puede comprar muy fácil’”, dijo. “Me preocupa más lo que viene, y que tengamos esta herramienta creo que nos prepara más hacia una demanda más alta de capacidad”.

Manzano agregó que VerificAudio ha contribuido a sensibilizar a los periodistas de W Radio sobre los niveles de alcance que tiene la IA en el periodismo, tanto para bien como para mal.

“Es un gran objetivo que tiene también esta herramienta, no solo identificar [contenido manipulado], sino también concientizar a nuestra redacción y ayudarles justo a aprender más acerca de él”, dijo Manzano.