La violencia digital contra periodistas es un fenómeno en incremento en América Latina. Ante esa situación, un grupo de periodistas de Brasil y México echaron mano de la inteligencia artificial para explorar el origen de las narrativas violentas contra periodistas en el mundo digital.

La Asociación Brasileña de Periodismo de Investigación (Abraji, por su acrónimo en portugués) y la organización mexicana sin fines de lucro de periodismo de datos Data Crítica unieron fuerzas para desarrollar “Attack Detector”, una herramienta que combina periodismo de datos y aprendizaje automático para detectar discurso de odio en línea.

Solo en Brasil, el entorno de esa violencia digital contra periodistas ha aumentado respecto a años anteriores. En su más reciente Monitoreo de las Agresiones a Periodistas en Brasil, publicado este 29 de marzo, Abraji reveló que a lo largo de 2022 se registraron más de 550 agresiones contra periodistas y medios de comunicación.

El reporte "Monitoreo de las Agresiones a Periodistas en Brasil 2022", publicado el 29 de marzo por Abraji, reveló que en 2022 se registraron más de 550 agresiones contra periodistas y medios de comunicación. (Foto: Abraji)

De ese total, 61.2 por ciento corresponde a episodios de violencia verbal o discurso estigmatizador, con 341 casos registrados. Y de esos, 298 casos (87.4 por ciento) se originaron en línea, principalmente en redes sociales.

Ante ese contexto, “Attack Detector”, un modelo de procesamiento de lenguaje natural (PLN), fue creado para detectar ataques a través de Twitter, no solo hacia periodistas, sino también hacia activistas ambientales y defensores del territorio en Brasil y México.

La herramienta fue desarrollada por Fernanda Aguirre, Gibrán Mena (de Data Crítica), Schirlei Alves y Reinaldo Chavez (de Abraji) como parte de su participación en la primera generación de la JournalismAI Fellowship, una iniciativa de JournalismAI, la organización con sede en la London School of Economics and Political Science (LSE) sobre periodismo e inteligencia artificial. El programa convocó a 46 periodistas y profesionales técnicos de medios de comunicación de 16 países en 2022 para desarrollar proyectos que exploren la aplicación responsable de la inteligencia artificial en periodismo.

“En Brasil tenemos este problema que no se ha terminado, en el que [se registran] discursos de odio en redes sociales contra diversos tipos de personas involucradas en cosas políticas, no solo periodistas, también mujeres en diversas posiciones de poder o personas de minorías y personas que defienden el medio ambiente”, dijo a LatAm Journalism Review (LJR) Chaves, coordinador de proyectos de Abraji. “Pensamos: ‘¿por qué no usar técnicas de machine learning para empezar a entender mejor esto?’. Y junto con Data Crítica hicimos un proyecto que aún está en una fase Beta, hay muchas cosas que pueden hacerse este año, pero con el cual ya podemos investigar de forma automatizada en una red social -Twitter- estos discursos contra periodistas y activistas ambientales”.

El equipo tomó como antecedente el Monitor de Discurso Político Misógino, la herramienta de detección de discurso de odio contra mujeres desarrollado en 2021 por Data Crítica, Revista AzMina, La Nación y CLIP, como parte del Collab Challenge, iniciativa antecesora de la JournalismAI Fellowship. Ese Monitor funcionaba mediante el entrenamiento de un modelo de PLN con diccionarios de términos misóginos que el modelo “aprendía”.

“Attack Detector”, por el contrario, está basado en modelos multilingües de código abierto, como RoBERTa, un modelo de PLN para el análisis de sentimiento (también llamado extracción de opiniones) que identifica el tono emocional detrás de determinado texto, entre otros.

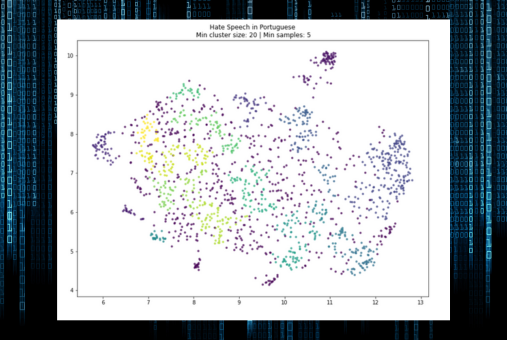

“Usamos el análisis de sentimiento para verificar la similitud o proximidad de palabras para entender si reflejan el mismo sentimiento. En nuestro caso, nosotros buscamos el odio. Con esto podemos ‘clusterizar’, separar grandes bloques de posts”, explicó Chaves. “En nuestro caso, esta clusterización la usamos para eso, para tener esos grados de posibilidad de odio”.

Antes de entrenar los modelos de PLN, el equipo hizo una investigación sobre cuáles eran los perfiles de periodistas y activistas más atacados en redes sociales, las palabras más usadas en dichos ataques y los tipos de perpetradores más frecuentes, entre otros criterios. Para ello, entrevistaron a expertos y organizaciones que siguen de cerca la violencia en línea contra miembros de la prensa, como Artículo 19, en el caso de México.

Al rastrear esos perfiles, seleccionaron una muestra de tweets dirigidos a periodistas y activistas frecuentemente atacados y etiquetaron manualmente aquellos que cumplían con las características de ataques con discurso de odio. Con esa información entrenaron los modelos de PLN, automatizando el análisis y luego optimizándolo.

Con la data obtenida por medio del modelo y metadatos como datos del usuario, fecha, hora y ubicación geográfica de los tweets se pueden hacer análisis de, por ejemplo, cómo surge el flujo de difusión de esos ataques, la interacción entre los usuarios y los tweets, y si existen comunidades ya establecidas para la creación y difusión de dichos ataques.

“También podemos saber en qué momentos del día suelen pasar [los ataques], porque si podemos identificar eso, quizá después podemos vincularlo con el contexto de lo que esté pasando en el país. Entonces, a lo mejor si pasó cierto suceso político o algún evento, podremos saber qué es lo que podría estar disparando ese ataque”, dijo Aguirre, quien también formó parte del equipo desarrollador del “Monitor de Discurso Político Misógino”.

El desarrollo de “Attack Detector” inició en junio de 2022 y tardó cerca de seis meses. Fue hasta noviembre de ese año que el modelo entró en una etapa piloto, en la que fue echado a andar para hacer monitoreo de las cuentas de Twitter seleccionadas.

Desde entonces hasta la fecha, el equipo sigue trabajando en optimizar el funcionamiento de la herramienta y busca ajustarla para que sea cada vez más capaz de identificar no solo ataques con palabras ofensivas específicas, sino agresiones con construcciones menos literales, como aquellas que incluyen ironía, insultos camuflados o ataques a la credibilidad de un periodista, por ejemplo.

“También hay que lidiar con frases que parecen ataques, pero son ironías y no hay computadora que consiga detectar con certeza cuándo es ironía o cuándo es ataque con discurso de odio. Esto solo [puede hacerlo] un ser humano que entienda, por ejemplo, la realidad de México o de Brasil”, dijo Chaves. “Hoy detectamos estos casos de ironía, pero son clasificados como ataques. Para que sean clasificados como ironía, tenemos que mejorar nuestra base de datos de entrenamiento, que es una de las prioridades y metas de este año”.

Fernanda Aguirre y Gibrán Mena, de Data Crítica (México); y Reinaldo Chaves y Schirlei Alves, de Abraji (Brasil) integraron el equipo desarrollador de "Attack Detector". (Foto: JournalismAI)

El equipo de “Attack Detector” alojó todo lo referente al modelo en un GitHub, y está habilitando un sitio web en el que se podrá descargar la base de datos de la herramienta y una serie de visualizaciones de datos con resultados del monitoreo. Algunas de esas visualizaciones muestran los usuarios con mayor rango de ataques, usuarios que más inician agresiones y periodistas y activistas más atacados, tanto en México como en Brasil.

Pese a que en diciembre pasado terminó el programa de la JournalismAI Fellowship, Abraji y Data Crítica planean seguir trabajando juntos en el entrenamiento de “Attack Detector” con recursos de ambas organizaciones. El siguiente paso, dijeron, es el desarrollo de una API (interfaz de programación de aplicaciones, por sus siglas en inglés) para que otras organizaciones puedan hacer uso del modelo para monitorear discurso de odio en línea en otros rubros. El equipo prevé que la API esté lista este mismo año.

“Queremos dejar la puerta abierta para que otras organizaciones lo usen por medio de la API”, dijo Aguirre. “Por ejemplo, en un periodo de elecciones en México, si hay alguna organización que monitoree violencia política, como el modelo detecta lenguaje sexista, se puede aplicar a muchas otras cosas, como monitorear candidatas para esas elecciones o a defensoras de la tierra, exclusivamente. Creo que su uso puede ser bastante amplio y adaptarse a distintos tipos de investigaciones”.

El uso de la inteligencia artificial en el periodismo siempre va acompañada de dilemas éticos y las herramientas de PLN no son la excepción. Conscientes de ello, los integrantes del equipo de “Attack Detector” se aseguraron de que su modelo tuviera cierto nivel de supervisión humana en todo momento.

Durante su entrenamiento para detectar discurso de odio, la herramienta era auditada constantemente para evaluar qué tan bien estaba haciendo su trabajo mediante una verificación manual de sus resultados.

“No es un proceso que esté del todo automatizado, porque siempre hay presencia humana en mayor o menor grado, aunque sea simplemente para evaluar y decir que el etiquetado fue correcto, pero no dejamos que sea algo que solo se decida por el algoritmo”, explicó Aguirre.

Cuando el modelo se topa con texto en el que el discurso de odio no es tan evidente o cuando éste viene disfrazado, el equipo interviene para hacer una segunda evaluación. De acuerdo con los desarrolladores de “Attack Detector”, los modelos de PLN no siempre siguen un patrón definido, además de que sus resultados no consideran factores de contexto.

“Attack Detector” está basado en modelos multilingües de código abierto para el análisis de sentimiento, que identifican el tono emocional detrás de determinado texto. (Foto: "Attack Detector")

“Es difícil clasificar [discurso de odio] solo a través de un robot y no tener la parte humana allí para entender realmente lo que está pasando en una avalancha de ataques”, dijo a LJR Alves, periodista de datos especializada en derechos humanos y la otra representante de Abraji en el equipo. “Ayuda en este esfuerzo de [manejar] un gran volumen de información, pero también es necesario tener a alguien allí para hacer el ajuste final, por así decirlo. Siempre hay que tener ese ojo humano para poder hacer la clasificación final de ver lo que realmente es y lo que no es [un ataque con discurso de odio].”

Al igual que los fenómenos sociales que analizan, los modelos informáticos como “Attack Detector” evolucionan y cambian con el tiempo, y por tanto deben ser sometidos a constante mantenimiento y actualización de las bases de datos con las que funcionan. Los representantes de Abraji y Data Crítica planean seguir probando nuevos modelos de PLN y análisis lingüístico para mejorar la precisión y el rendimiento de la herramienta.

El equipo espera en un futuro cercano hacer alianzas con otras organizaciones de defensa de la libertad de expresión, tanto de Brasil y México como de otros países. Prevén que el modelo pueda tener una aplicación práctica en el entendimiento de la violencia digital contra periodistas y su combate y que la capacidad de “Attack Detector” pueda ser ampliada para que actúe no solo con contenido de Twitter, sino también de otras plataformas donde existe violencia con discurso de odio, como Facebook, Instagram y TikTok.

“Hemos notado que hay violencia digital, lamentable y bastante frecuente contra periodistas y defensores del medioambiente en Facebook”, dijo a LJR Mena, cofundador de Data Crítica. “Estamos en busca de amplias alianzas y de financiamiento para ampliar los esfuerzos, primero en el desarrollo de análisis de otras plataformas, como Facebook, y después en crear estrategias de impacto donde podamos lograr que una herramienta como ésta tenga un claro impacto en la disminución de la violencia digital contra contra periodistas”.

La segunda edición de la JournalismAI Fellowship se llevará a cabo este año y ya está abierto el registro para quienes deseen desarrollar nuevos proyectos que vinculen el uso de la inteligencia artificial con el periodismo.

JournalismAI convoca a periodistas y profesionales técnicos de medios de comunicación de todo el mundo para participar en el programa, el cual es gratuito y se desarrolla completamente de manera virtual.

“A diferencia de otros programas, la JournalismAI Fellowship no seleccionará becarios individuales, sino que se seleccionará un máximo de 15 parejas de becarios para unirse a la generación de 2023. Estas parejas formarán equipos con los cuales trabajarán durante seis meses para crear soluciones basadas en inteligencia artificial que mejoren el ejercicio periodístico” dijo Lakshmi Sivadas, gerente del programa, a LJR.

La JournalismAI Fellowship se llevará a cabo de junio a diciembre de 2023 y los seleccionados deberán dedicar al menos ocho horas por semana para el desarrollo de sus proyectos. Cada equipo recibirá apoyo financiero, así como mentorías y entrenamiento por parte de expertos en el uso de inteligencia artificial en el periodismo.

La recepción de solicitudes cierra el 21 de abril.