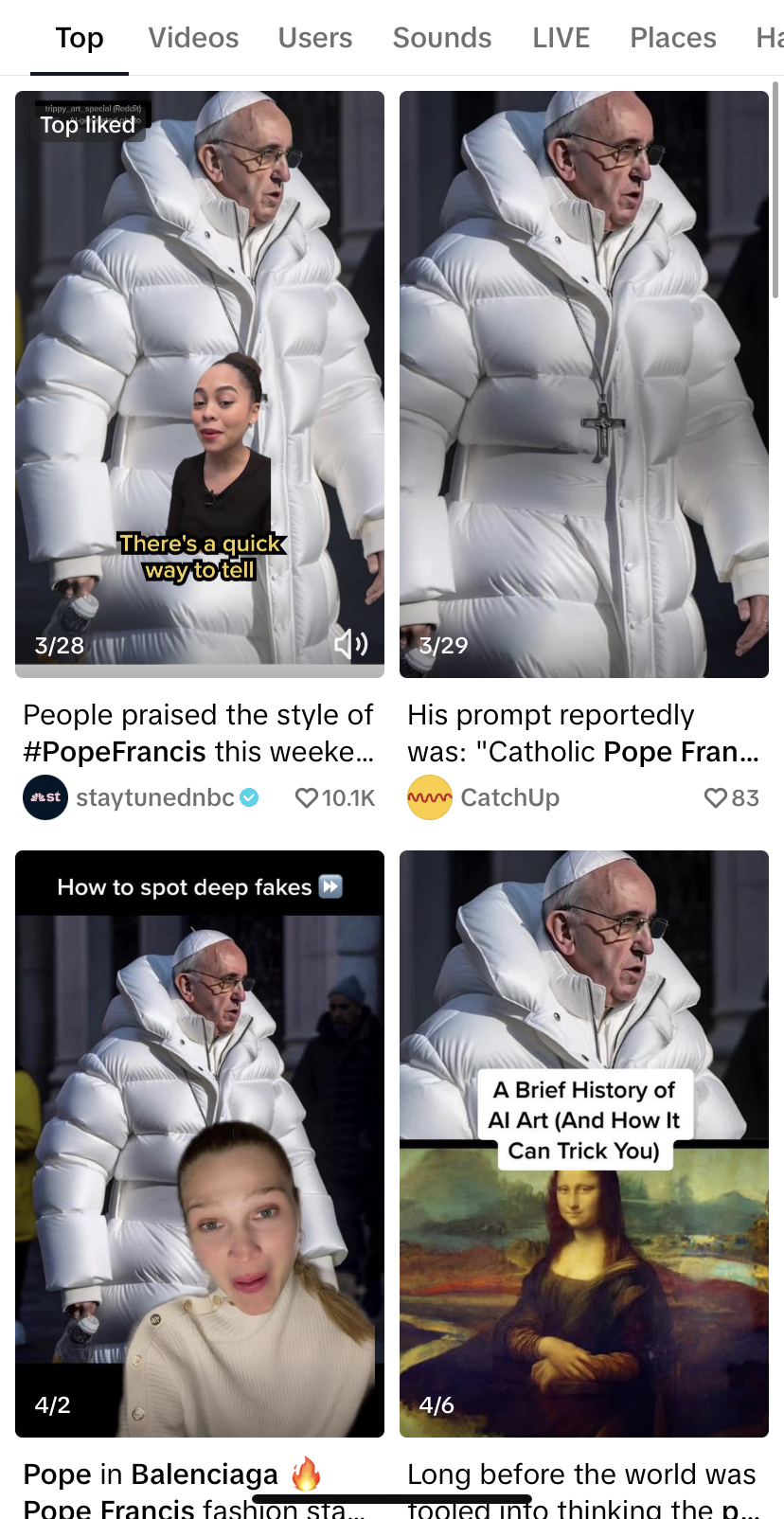

Una imagen del Papa Francisco portando un abrigo blanco Balenciaga tipo puffer y una serie de fotografías del expresidente estadounidense Donald Trump siendo sometido por policías causaron controversia en medios de comunicación y redes sociales en marzo de este año. No pasó mucho tiempo antes de que fact-checkers de todo el mundo aclararan que se trataba de imágenes creadas por la aplicación de inteligencia artificial generativa Midjourney, la cual fabrica imágenes a partir de descripciones en lenguaje natural.

Materiales falsos e hiperrealistas como los anteriores han encendido focos rojos por su alta capacidad de generar desinformación y manipular a la opinión pública. Por varios años, verificadores de contenido y empresas tecnológicas han tratado de hallar una respuesta contundente para contrarrestar el poder de los deepfakes, como se les conoce a las piezas audiovisuales creadas por inteligencia artificial que parecen auténticas pero son falsas.

Una proyecto denominado Content Authenticity Initiative (CAI), liderado por la empresa de software Adobe, busca combatir la desinformación mediante la implementación generalizada de un estándar tecnológico que proporcione información sobre el origen y las alteraciones del contenido digital en internet.

La iniciativa busca involucrar a varias industrias, incluidos medios de comunicación, empresas tecnológicas y fabricantes de dispositivos, alrededor de un protocolo de código abierto con interoperabilidad entre múltiples herramientas.

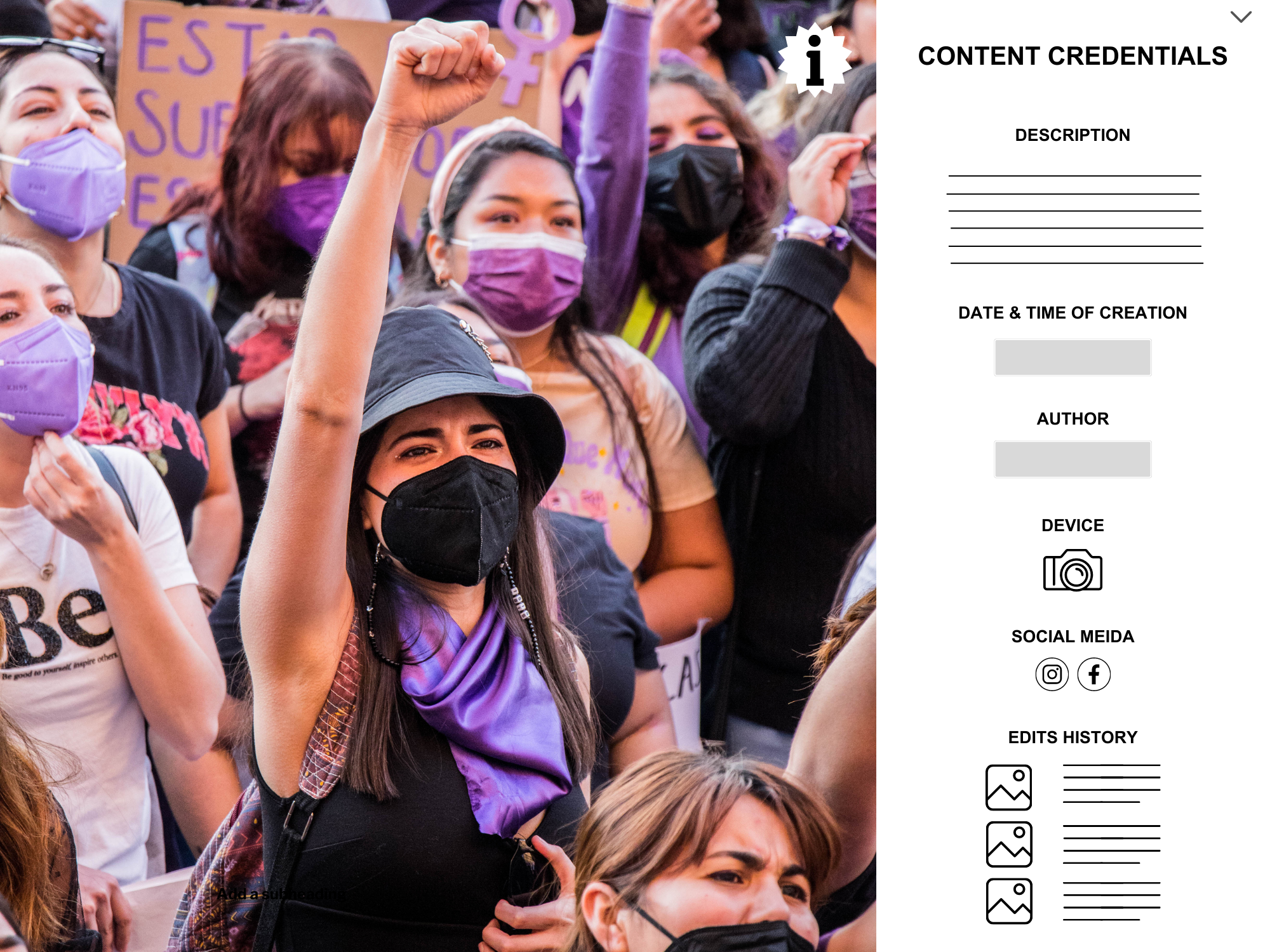

Representación de cómo se desplegarían las credenciales de contenido de una foto en internet, de acuerdo con la descripción de la Content Authenticity Initiative. (Foto: Norma Galván vía Canva.com)

“Con la llegada de la inteligencia artificial, llegó la posibilidad de una gran proliferación de información falsa aún más difícil de detectar”, dijo a LatAm Journalism Review (LJR) el periodista John Reichertz, consultor de la CAI para América Latina. “Lo que la iniciativa busca es tratar de dar al público elementos con la idea de la transparencia, que es un valor del periodismo, para que puedan determinar si una imagen, una videograbación y eventualmente un documento, es real o falso”.

El estándar tecnológico de código abierto de la iniciativa permitirá integrar en el material digital “credenciales de contenido”. Es decir, datos de procedencia que ofrezcan a los usuarios información contextual a prueba de manipulaciones sobre los cambios realizados a los contenidos a lo largo del tiempo, desde su gestación en un dispositivo hasta su publicación en un medio o plataforma, incluidos datos sobre su identidad, los tipos de edición utilizados y las modificaciones ejecutadas.

La CAI plantea que, una vez implementado el estándar, cada imagen y video en internet incluirá un símbolo de información (i) en el ángulo superior derecho, el cual, al hacer clic en él, mostrará los datos de procedencia y alteraciones. En una versión posterior, la herramienta permitirá incluso visualizar las diferentes versiones de cada pieza de contenido, entre el archivo original hasta el archivo publicado, dijo Reichertz.

“Es muy similar a cuando vas a comprar una lata de tomates en el supermercado y ves una lata que dice solamente ‘tomates’ y no tiene ninguna otra información, y ves otra que tiene una etiqueta de nutrición con fecha de envase, fecha de vencimiento, que además de tomates hay agua, sodio, colorantes, conservadores, etcétera”, explicó. “Casi seguro que vas a tomar la lata que tiene información. Es el mismo concepto de que estás consumiendo un producto y quieres saber más sobre su origen y sobre cómo es el contenido”.

Las imágenes del Papa y de Trump de este año no fueron los primeros deepfakes en hacerse virales. En 2017, investigadores de la Universidad de Washington crearon un video falso de Barack Obama a partir de una técnica de inteligencia artificial que “aprendió” a reproducir con precisión los movimientos del expresidente al hablar.

La diferencia es que actualmente para generar imágenes falsas hiperrealistas no se requiere a un grupo de expertos en inteligencia artificial. Casi cualquier persona puede crearlas en aplicaciones como Midjourney, Dall-E o Stable Difussion, lo cual podría llevar a un punto en el que no se sepa distinguir qué contenidos en internet son reales y cuáles no.

“Antes para falsificar [material] tenías que entender Photoshop o algún otro programa, tenías que tener cierta habilidad y también invertir en un programa”, dijo Reichertz, quien fue editor para América Latina de las agencias Reuters y EFE. “Hoy en día cualquiera lo puede hacer y eso tiene varias implicaciones”.

Una de esas implicaciones es que la desconfianza de la gente en los medios podría acrecentarse aún más, dijo el periodista. De acuerdo con la más reciente edición del Digital News Report del Reuters Institute, a más de la mitad de los encuestados a nivel mundial se les dificulta distinguir entre noticias reales y falsas en internet, Eso, en un ecosistema de información contaminado con contenido alterado, termina por afectar la credibilidad de la gente en toda fuente de información, incluidos los medios de noticias.

“La gente tiene mucho problema en distinguir entre qué es real y qué no es real. Cuando uno empieza a dudar qué es real y qué no es real, empieza a poner en duda todo, y eso para la industria de los medios es, en mi opinión, una crisis existencial, porque el valor más alto del producto periodístico es tu credibilidad”, dijo.

Por el momento, la CAI está poniendo gran énfasis en la implementación de su estándar tecnológico en la fotografía. Sin embargo, se espera que en los años siguientes todo tipo de contenido digital incluya datos de origen y alteraciones.

Aunque la iniciativa está aún en etapas tempranas y todavía ningún fabricante de dispositivos fotográficos lo ha puesto en práctica, dos marcas de cámaras -Nikon y Leica- se han comprometido a implementar el código de la CAI en sus equipos más utilizados por profesionales, dijo Reichertz. Por su parte, Truepic, una empresa especializada en autenticidad de contenido digital, está desarrollando un software para que el estándar tecnológico pueda funcionar en teléfonos inteligentes.

Además, Adobe ya incluyó la función de credenciales de contenido en una versión Beta de Photoshop, uno de los programas de edición de imágenes más populares, así como en Firefly, su producto de inteligencia artificial generativa.

La Content Authenticity Initiative busca implementar su estándar tecnológico a lo largo de todo el proceso del contenido en internet. (Gráfico: César López Linares)

Pese a que todas las agencias internacionales de Occidente se han sumado a la CAI, incluidas AP, Reuters, AFP, EFE y DPA, Reichertz dijo que todavía no está claro cuándo éstas comenzarán a integrar las credenciales de contenido a las imágenes que envíen a los medios de comunicación.

No obstante, en un futuro muy próximo será posible comenzar a incluir las credenciales de la etapa de edición en adelante. El equipo detrás de la iniciativa está trabajando para sumar al proyecto a los desarrolladores de CMS (sistemas de gestión de contenido, por sus siglas en inglés) de los medios de comunicación, con el objetivo de lograr una total interoperabilidad del estándar tecnológico a todo lo largo del proceso.

“Lo que se podría hacer hoy es de la edición en adelante, lograr que [el archivo con credenciales] pase por el CMS y salga publicado en el medio, para que en el momento en que las agencias empiecen a mandar información con credenciales, fluya directamente por el sistema automáticamente”, dijo Reichertz. “O cuando las cámaras y los smartphones empiecen a tener las credenciales desde el inicio, que fluya por todo el sistema”.

Las credenciales de contenido de la CAI tienen como antecedente los metadatos de las fotografías tomadas con cámaras digitales y teléfonos inteligentes, los cuales comúnmente incluyen fecha de la imagen, lugar, dispositivo, medidas, entre otros.

La diferencia es que, mientras que los metadatos de las fotos digitales actuales se pierden una vez editado o exportado el material, las credenciales de la CAI están vinculadas de forma segura con el archivo y aunque se intente alterarlas, estos intentos quedarán también reflejados en los metadatos.

“Si sacas una foto con tu smartphone, puedes ver dónde la sacaste y en qué momento. Pero esa no es información segura, no está vinculada de una forma segura al archivo de la fotografía y los datos se pueden borrar o cambiar”, explicó Reichertz. “En este modelo es todo seguro: está encriptado y la información de la foto y de su procedencia están íntimamente vinculados para que uno no pueda alterar esa información”.

Las herramientas de la CAI para la autenticidad y procedencia de contenidos digitales son de código abierto y están disponibles para que cualquier empresa, medio o desarrollador las pueda usar para crear aplicaciones o integrarlas a sus sistemas. Aunque no tienen costo, requieren de una inversión para su implementación. Y sobre todo, requieren de un esfuerzo colaborativo entre fabricantes de dispositivos, desarrolladores de software, medios de comunicación y plataformas de redes sociales, dijo Reichertz.

Lo que buscan actualmente los representantes de la CAI es crear un sentido de urgencia entre todos los actores interesados en el mundo digital, presentarles la iniciativa y promover el uso del protocolo tecnológico.

“Tiene que haber una presión apabullante para que todos los actores del ecosistema digital accedan a incluir esto como algo básico en su servicio o productos”, dijo Reichertz. “Eso es el objetivo, que esto no sea una opción nice to have. La presión que viene hoy en día es que esto debería ser parte del servicio básico, sin un costo adicional, y que todos estamos de acuerdo”.

La CAI ha sumado a más de 1.300 miembros en todo el mundo, entre ellos medios de comunicación de prestigio mundial como The New York Times, The Washington Post y The Wall Street Journal.

La iniciativa llegó a América Latina en septiembre de 2022, cuando Reichertz y su equipo comenzaron a presentar el proyecto a los principales grupos de noticias y asociaciones de medios de comunicación. Hasta julio de 2023, los medios y organizaciones latinoamericanos que han dado su respaldo a la iniciativa superan los 50. Entre ellos figuran la Asociación de Entidades Periodísticas Argentinas (ADEPA), la Associação Nacional de Jornais (ANJ), la Asociación de Medios de Información de Colombia (AMIC) y la Alianza de Medios de México.

La foto del Papa Francisco con un lujoso abrigo causó controversia en redes sociales por tratarse de una imagen creada por el sitio de inteligencia artificial generativa Midjourney. (Foto: Captura de pantalla de TikTok)

Entre los medios de América Latina que se han sumado están organizaciones de verificación como Ecuador Chequea (Ecuador), ColombiaCheck (Colombia), Verificado (México), Chequeado, Proyecto Desconfío (Argentina) y Comprova (Brasil), así como medios como El Tiempo, El Espectador (Colombia), Infobae (Argentina), El Mostrador, La Razón (Chile) y Perú21 (Perú), entre otros.

En esta etapa, la misión de los representantes de la CAI en América Latina es que la iniciativa se conozca y lograr el apoyo de los medios de la región. Por lo pronto, la iniciativa creó un canal en Discord en el que los miembros pueden comentar sobre cuestiones técnicas, y en el que se llevan a cabo discusiones sobre el proyecto.

De acuerdo con algunos fact-checkers latinoamericanos miembros, si bien la CAI no llegará a reemplazar su trabajo de verificación, sí complementará sus estrategias tradicionales de lucha contra la información falsa.

“Las soluciones para combatir la desinformación son múltiples y colaborativas, y han tenido poco efecto cuando se han aplicado de forma aislada. Por eso, buscamos apoyar todas las iniciativas que puedan colaborar con la mejora del ambiente informativo”, dijo a LJR Sérgio Lüdtke, editor en jefe del Proyecto Comprova, una coalición de 24 medios de comunicación para verificar contenidos falsos en Brasil. “Entendemos que no podíamos quedar fuera de este esfuerzo conjunto para promover la adopción de un estándar abierto de la industria para la autenticidad y procedencia de los contenidos que circulan por internet y las redes sociales”.

Ana María Saavedra, directora de ColombiaCheck, dijo que el hecho de que las organizaciones líderes en fact-checking de América Latina se hayan sumado a la CAI les dio la confianza para unirse como miembros. Aunque hasta el momento no han iniciado la implementación del protocolo tecnológico, en los próximos meses llevarán a cabo reuniones para plantear los pasos a seguir para la puesta en práctica de la iniciativa.

“Consideramos que es un proyecto que puede aportar en la lucha contra la desinformación”, dijo. “No es un compromiso muy grande porque no es que hayamos firmado un documento en el que nos comprometemos a hacer algo con lo que no estemos seguros o que vaya en contra de nuestros lineamientos, sino que es algo que busca apoyar para poder identificar las desinformaciones”.

Las organizaciones de verificación tienden a enfocarse en el material más viral o de mayor alcance, dijo Lüdtke. Y las credenciales de contenido contribuirían a evitar que piezas manipuladas alcancen esa viralidad y lleguen a desinformar al público. El editor en jefe de Comprova dijo que espera que las herramientas de autenticidad y procedencia de contenidos digitales de la CAI sirvan para preparar a sus equipos para cuando se enfrenten a la verificación de deepfakes.

Tanto Lüdtke como Saavedra coincidieron en que estas herramientas funcionarán de forma complementaria con las técnicas de verificación periodística que emplean los fact-checkers, como la búsqueda inversa y el análisis de detalles.

“Nosotros tenemos un paso a paso para la verificación de deepfakes, imágenes modificadas, o imágenes hechas con inteligencia artificial”, dijo Saavedra. “Hacer periodismo de verificación del contexto de la foto, de la veracidad de esa foto, todos los elementos que uno tiene que analizar también en un chequeo”.

Para Adrián Pino, coordinador de la organización de verificación de datos argentina Proyecto Desconfío, la cual ofrece capacitaciones sobre fact-checking a periodistas de la región, la CAI es una oportunidad para explorar estándares que aceleren el proceso de verificación de contenido sospechoso.

“Cuantas más señales podamos generar para distinguir contenido auténtico de contenido falso, manipulado o engañoso, más oportunidades tenemos de hacer llegar contenido confiable a los ciudadanos”, dijo Pino a LJR. “En la medida que más agencias y medios adopten este estándar, más rápido será el trabajo de verificación”.

Reichertz dijo que la CAI no se presenta como una solución definitiva para la desinformación en contenido digital y coincidió en no viene a reemplazar la labor de los periodistas.

“Hay pocas soluciones concretas [para la desinformación], y aunque ésta [la CAI], siendo concreta, no es completa. Es una ayuda adicional para combatir la desinformación, pero no es la solución”, dijo. “Los fact-checkers los saben muy bien y saben muy bien los desafíos que van a tener con la inteligencia artificial y saben muy bien que no se darán abasto para llegar a todo”.

Banner: Imágenes generadas por inteligencia artificial en Bing Image Creator