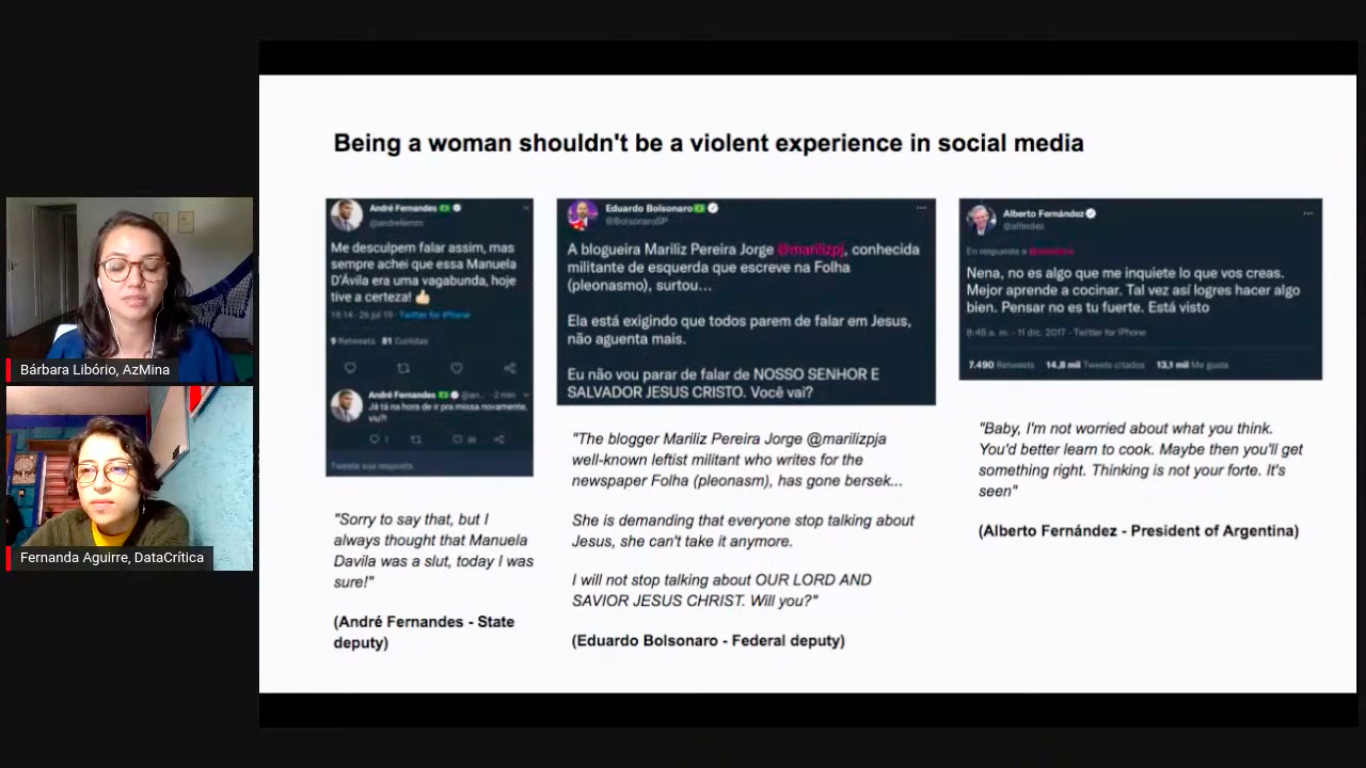

As jornalistas da revista digital feminista AzMina, do Brasil, notaram que grande parte da violência contra as mulheres em seu país teve origem nas redes sociais. Elas queriam investigar sobre o assunto e para isso desenvolveram uma metodologia de monitoramento da violência online.

Sob essa metodologia, desde 2020 a AzMina publica uma série de investigações de dados, em aliança com organizações como InternetLab, Volt Data Lab e INCT.DD, que revelam como as mulheres na política e no jornalismo são vítimas de ataques e insultos nas redes sociais que tentam deslegitimar sua capacidade intelectual para o exercício de suas profissões.

O Monitor de Discurso Político Misógino foi desenvolvido como parte do Collab Challenge, uma iniciativa do JournalismAI e da Google News Initiative. (Foto: captura de tela da transmissão ao vivo do YouTube)

“Tínhamos que ler e analisar tweet por tweet, comentário por comentário”, disse Bárbara Libório, gerente de jornalismo e projetos da AzMina, à LatAm Journalism Review (LJR). “Tivemos muito trabalho manual e humano, lendo muitos tweets, muitas publicações, muitos comentários. Pensamos 'como eu gostaria que a inteligência artificial pudesse fazer isso por nós, porque faria isso de forma muito mais assertiva e muito mais rápida'. Somos uma equipe muito pequena e tivemos que fazer muitas outras coisas ao mesmo tempo, o que exigiu muito tempo e esforço, e pensamos que a inteligência artificial poderia nos ajudar.”

Por isso, quando Libório e mais duas integrantes da equipe AzMina foram aceitas para participar do Collab Challenge 2021, iniciativa global do JournalismAI e da Google News Initiative que reúne meios de todo o mundo para desenvolver inovações no jornalismo por meio da inteligência artificial, decidiram apresentar como um projeto para desenvolver sua metodologia de monitoramento da violência online contra mulheres, com o objetivo de criar uma ferramenta que será útil na cobertura das próximas eleições presidenciais de 2022 no Brasil.

“Sabíamos que queríamos continuar com o monitor, mas precisávamos de ajuda tecnológica, não apenas manual e humana, então achamos que seria uma boa ideia [...] ter algum aprendizado que pudéssemos levar de volta para nossa equipe e nosso projeto”, disse Libório. “Mas quando apresentamos nossa ideia, vimos que outras organizações também estavam interessadas em tal ferramenta, não só pela questão de gênero e machismo, mas pela questão do discurso de ódio em geral”.

Libório e suas colegas da AzMina Helena Bertho e Marina Gama Cubas da Silva formaram uma equipe com Fernanda Aguirre, do Data Crítica (México); Gaby Bouret, do La Nación (Argentina); e José Luis Peñarredonda, do CLIP (Colômbia) para desenvolver o que viria a ser o Monitor de Discurso Político Misógino.

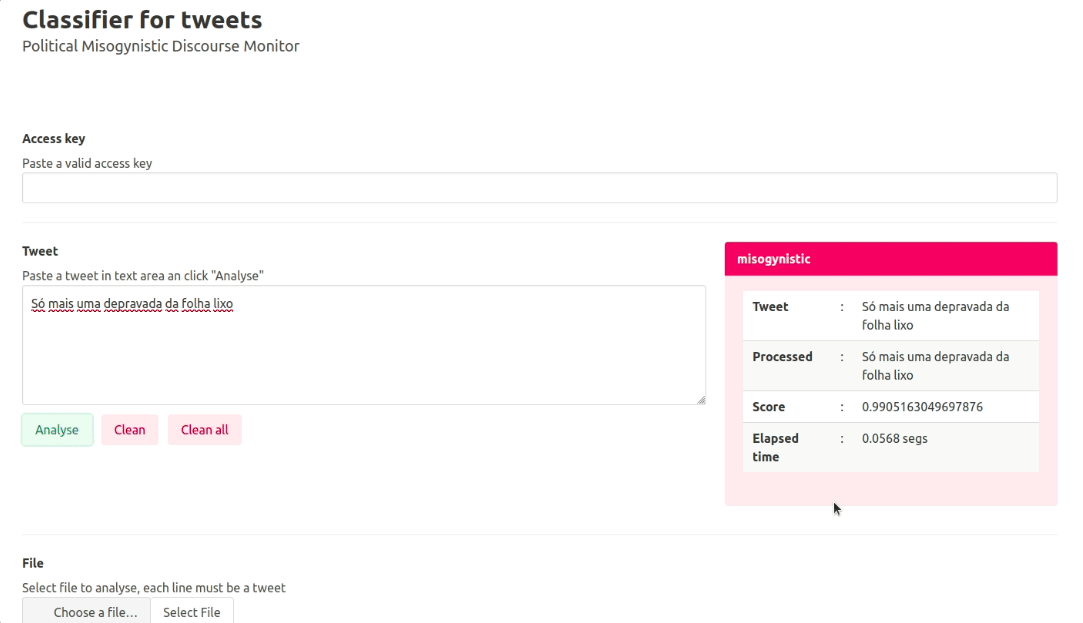

É uma API (interface de programação de aplicativos) que, por meio de um modelo treinado de Processamento de Linguagem Natural (NLP), detecta discursos de ódio contra mulheres na internet em espanhol e português. A ferramenta tem o potencial de automatizar a análise de postagens online usando aprendizado de máquina para que os jornalistas possam se concentrar em tarefas mais cruciais em suas investigações sobre violência de gênero.

“Encontramos muitos projetos que tentam monitorar o discurso de ódio com inteligência artificial, mas não são tantos que fazem isso em torno da misoginia”, disse Libório. “Para jornalistas, acho que o principal problema é o tempo que nos custa, porque é muito tempo e esforço que investimos em ler todas as publicações e analisar se são ataques misóginos ou não. Se tivermos uma inteligência artificial que faça isso por nós com assertividade e escalabilidade, teríamos muito tempo para focar nossos esforços em outras coisas, como realizar entrevistas ou buscar os perfis que estão realizando os ataques, ou fazer investigações mais profundas, com mais tempo.”

O primeiro passo na construção do Monitor foi atualizar o dicionário de termos misóginos que a AzMina havia criado para seus projetos de monitoramento de comentários misóginos online. Esses termos foram usados para treinar um modelo de aprendizado de máquina de PLN.

Os participantes de Data Crítica, La Nación e CLIP também criaram seus próprios dicionários de espanhol baseados no dicionário da AzMina. Eles compilaram termos ofensivos contra as mulheres nas redes sociais e os ordenaram por tipo de ofensas, como insultos devido à aparência física, raça, ataques ao intelecto, ofensas transfóbicas e ataques sexuais, entre outros.

“Achávamos que era algo tão simples quanto traduzir o dicionário do português e pronto. Mas não foi tão fácil assim. Muitas coisas em espanhol não faziam sentido ou não eram misóginas", disse Aguirre, analista de dados da Data Crítica, à LJR. “Percebemos que no final é algo que depende muito do contexto e que parece ser muito fácil identificar se um tweet é misógino e a verdade é que às vezes não era tão fácil.”

A equipe utilizou o modelo de processamento de linguagem natural BERT (sigla em inglês para Representações de Codificador Bidirecional de Transformadores), desenvolvido pelo Google, que é capaz de “aprender” as relações contextuais entre palavras em um texto. A equipe selecionou uma amostra de tweets em português e espanhol que incluíam as palavras contidas em dicionários e marcou manualmente aquelas que poderiam ser consideradas misóginas. Eles então usaram essa amostra para treinar o modelo para identificar tweets que eram misóginos.

A ferramenta tem o potencial de automatizar a análise de tweets por meio de aprendizado de máquina, para que os jornalistas possam se concentrar em tarefas mais cruciais. (Foto: Cortesia)

"Em geral, todos esses modelos entendem coisas de linguagem porque foram alimentados por muito texto", explicou Aguirre. “Você pega esse modelo e refina esse conhecimento para que ele aprenda algo muito específico, que no nosso caso foi 'você já sabe coisas sobre linguagem, agora queremos que você aprenda a identificar textos que são misóginos'. Isso pode ser usado para muitas coisas, mas nosso alvo era o discurso misógino."

A equipe contou com o apoio de Iván Vladimir Meza, pesquisador especialista em computação de linguagem humana da Faculdade de Engenharia da Universidade Nacional Autônoma do México (UNAM), para o treinamento do modelo BERT e a posterior criação da API do Monitor.

Após fazer um primeiro treinamento, a equipe descobriu que o modelo detectou tweets que continham palavras consideradas misóginas, mas que foram escritas sem a intenção de ofender, o que gerou “falsos positivos” de discurso misógino.

Da mesma forma, os jornalistas perceberam que a cultura e o contexto de cada país influenciam significativamente a interpretação do conteúdo misógino. Por exemplo, alguns termos considerados misóginos na Colômbia não o são no México ou na Argentina e vice-versa. Então, a equipe teve que verificar novamente a rotulagem dos tweets para garantir que eles fossem intencionalmente misóginos.

“Eu marcava os [tweets] do México e depois conferia os da Gaby da Argentina e via se concordava com o que ela tinha marcado. E Gaby verificou os de José Luis e ele verificou os meus”, explicou Aguirre. “Se um não concordasse com a marcação de outro, esse tweet era removido do banco de dados. Nós só incluímos a marcação onde tanto o marcador quanto o verificador concordaram que era misógino."

Também após o primeiro treinamento, a equipe percebeu que o BERT funcionava com mais precisão em espanhol do que em português, embora em nenhum dos dois idiomas a eficácia fosse tão alta quanto em inglês. Foi então que decidiram realizar um segundo treinamento, desta vez com modelos diferentes para cada idioma. Terminada a participação no Collab Challenge, a equipe decidiu realizar uma terceira sessão de treinamento para refinar ainda mais os resultados em português.

“Tivemos esse desafio de que o PLN em inglês é muito melhor, em espanhol funciona bem e em português, mais ou menos... Na nossa formação, os resultados em espanhol têm sido melhores que os resultados em português”, disse Libório. “Acho que esta terceira sessão de formação vai ajudar-nos um pouco a esclarecer as nossas ideias”.

Ao longo do processo, tanto Libório quanto os demais integrantes perceberam que o monitoramento de discurso é uma tarefa praticamente interminável devido à evolução natural da linguagem humana e às mudanças no contexto social. Embora a equipe da AzMina já tivesse dicionários de termos misóginos de seus trabalhos anteriores, atualizá-los com novas formas de agressão às mulheres nas redes significava fazer praticamente todo o trabalho novamente.

“A língua é uma coisa muito viva, por isso é um trabalho que nunca acaba. Sempre que você for trabalhar com linguagem tem que pensar que é algo muito vivo que deve estar sempre atualizado”, disse Libório. “Isso dá um pouco de ansiedade, porque tem aquela sensação de que o trabalho nunca termina e é importante ter em mente quando você vai estimar seus esforços”.

Como resultado de sua participação no Collab Challenge, os jornalistas de AzMina, Data Crítica, La Nación e CLIP descobriram que ainda é muito difícil para um meio de comunicação latino-americano criar inovação em inteligência artificial por conta própria, não apenas por pela falta de recursos econômicos, mas também pela falta de conhecimento técnico. Da mesma forma, eles aprenderam que a colaboração entre jornalistas e profissionais experientes em tecnologia é crucial para desenvolver uma ferramenta como o Monitor de Discurso Político Misógino.

Além da aliança com o engenheiro da UNAM, os jornalistas tiveram a orientação técnica de Jeremy Gilbert, Joe Germuska e Scott Bradley do Knight Lab da Northwestern University, nos Estados Unidos, organização que serviu como aliada regional e ponto de contato entre a equipe e os organizadores do Collab Challenge.

“Como jornalistas de dados, sabemos o que precisamos e temos essas ideias, mas não temos o conhecimento técnico. Por isso fizemos a aliança com o Iván (Meza)”, disse Libório. “Tivemos que buscar uma aliança com alguém que não fosse jornalista, porque acho que existe aquela lacuna de que como jornalistas sabemos o que gostaríamos de fazer, como deveria ser a ferramenta, o que deveria ter, mas não temos o conhecimento técnico para realizá-lo”.

A AzMina planeja continuar aplicando sua metodologia de monitoramento à violência de gênero online. (Foto: Instagram da AzMina)

A aliança com Meza também significou apoio financeiro indireto. Como pesquisador do Instituto de Matemática Aplicada e Pesquisa de Sistemas (IIMAS) da UNAM, o engenheiro conseguiu usar um dos servidores da instituição para hospedar a API do Monitor e mantê-la lá por até dois anos, enquanto os meios por trás do projeto encontram uma forma de financiar uma hospedagem por conta própria.

"Muitas vezes a academia tem meios para apoiar esse tipo de projeto", disse Aguirre. “Provavelmente se não tivéssemos feito essa colaboração com o Iván, não sei como teríamos resolvido tudo isso, pagando a hospedagem, o servidor... Por isso acho que a colaboração pode ser fundamental para pequenos meios como é o nosso caso. Sem a colaboração com outros meios e com Iván e seu laboratório, não teríamos conseguido fazer o que fizemos ou seria muito caro e não conseguiríamos mantê-lo”.

Embora a ferramenta já seja funcional e possa ser utilizada, o plano da equipe é otimizar ao máximo sua operação antes de aplicá-la em investigações jornalísticas. Assim que atingir um nível ideal de precisão, eles planejam disponibilizá-la para outros meios como uma ferramenta de código aberto.

“Gostaríamos que essa API fosse aberta para que outras redações e outras pessoas pudessem testá-la ou colocar o texto de um tweet, uma publicação lá e ter uma resposta”, disse Libório. “Estamos procurando bolsas de estudo e oportunidades que talvez possamos obter para conseguir mais financiamento para o projeto.”

As vantagens de um modelo de inteligência artificial como o Monitor de Discurso Político Misógino é que ele pode ser treinado para detectar muitos outros tipos de discurso e em outras plataformas de texto escrito além do Twitter. Embora, no momento, o Data Crítica veja um grande potencial para estender sua aplicação no combate à violência contra mulheres jornalistas no México.

“Inicialmente, imaginamos continuar o trabalho da AzMina sobre violência contra as mulheres na política e estendê-lo para ver o que estava acontecendo com as mulheres na política no México ou na Colômbia”, disse Aguirre. “Mas depois imaginei muito como essa ferramenta pode ser aplicada – especificamente no México – na violência contra mulheres jornalistas. Essa ferramenta aplicada ao jornalismo é interessante para entender essa onda de violência contra as mulheres e como podemos usá-la para ajudar as jornalistas que estão sendo atacadas.”

Por sua vez, a AzMina espera poder aplicar o Monitor de Discurso Político Misógino em sua cobertura das eleições brasileiras de 2022, além de continuar aplicando sua metodologia de monitoramento a outras questões de gênero, como em seu projeto “Elas no Congresso”, indicado ao Prêmio Gabo 2020 na categoria Inovação, que monitora projetos de lei ou iniciativas que tratam dos direitos das mulheres no Congresso brasileiro com base em dados públicos.

“As pessoas têm que entender que é muito bom ver uma inteligência artificial em funcionamento, mas que há muito trabalho humano antes disso”, disse Libório. “Todo mundo gosta de ver a inteligência artificial funcionando, mas ninguém gosta de marcar tweets, posts, ler milhares de textos. Tudo isso é essencial, porque se não houver trabalho humano para tornar os dados eficazes, para termos certeza do que estamos fazendo, a inteligência artificial não funcionará. É muito importante que este trabalho também seja valorizado”.