A violência digital contra jornalistas é um fenômeno crescente na América Latina. Diante dessa situação, um grupo de jornalistas do Brasil e do México recorreu à inteligência artificial para explorar a origem das narrativas violentas contra jornalistas no mundo digital.

A Associação Brasileira de Jornalismo Investigativo (Abraji) e a organização mexicana sem fins lucrativos de jornalismo de dados Data Crítica uniram forças para desenvolver o “Attack Detector” ("Detector de Ataques"), uma ferramenta que combina jornalismo de dados e aprendizagem de máquina para detectar discurso de ódio online.

No Brasil, o ambiente de violência digital contra jornalistas aumentou em relação a anos anteriores. Em seu mais recente Monitoramento de ataques a jornalistas no Brasil, publicado em 29 de março, a Abraji revelou que mais de 550 ataques contra jornalistas e veículos de comunicação foram registrados em 2022.

O relatório "Monitoramento de ataques a jornalistas no Brasil 2022", publicado em 29 de março pela Abraji. (Foto: Abraji)

Desse total, 61,2% correspondem a episódios de violência verbal ou discurso estigmatizante, com 341 casos registrados. E desses, 298 casos (87,4%) tiveram origem online, principalmente em redes sociais.

Neste contexto, "Attack Detector", um modelo de processamento de linguagem natural (PLN), foi criado para detectar ataques no Twitter, não apenas contra jornalistas, mas também ativistas ambientais e defensores da terra no Brasil e no México.

A ferramenta foi desenvolvida por Fernanda Aguirre, Gibrán Mena (da Data Crítica), Schirlei Alves e Reinaldo Chavez (da Abraji) como parte de sua participação na primeira geração da JournalismAI Fellowship, uma iniciativa da JournalismAI, organização de jornalismo e inteligência artificial sediada na London School of Economics and Political Science (LSE). O programa convocou 46 jornalistas e profissionais técnicos de meios de comunicação de 16 países em 2022 para desenvolver projetos que explorassem a aplicação responsável da inteligência artificial no jornalismo.

"No Brasil temos este problema, que ainda não terminou, de discurso de ódio nas redes sociais contra vários tipos de pessoas envolvidas em coisas políticas, não só jornalistas, mas também mulheres em vários cargos de poder ou pessoas de minorias e pessoas que defendem o meio ambiente", disse Chaves, coordenador de projetos na Abraji, à LatAm Journalism Review (LJR). "Pensamos: 'por que não usar técnicas de aprendizagem de máquina para começar a entender melhor isto?' E junto com Data Crítica fizemos um projeto que ainda está em fase Beta, há muitas coisas que podem ser feitas este ano, mas com as quais já podemos investigar de forma automatizada em uma rede social – Twitter – estes discursos contra jornalistas e ativistas ambientais".

A equipe tomou como antecedente o Monitor do Discurso Político Misógino, a ferramenta de detecção de discurso de ódio contra mulheres desenvolvida em 2021 por Data Crítica, Revista AzMina, La Nación e CLIP, como parte do Collab Challenge, a iniciativa predecessora da JournalismAI Fellowship. Esse Monitor funcionava por meio do treinamento de um modelo PLN com dicionários de termos misóginos que o modelo "aprendia".

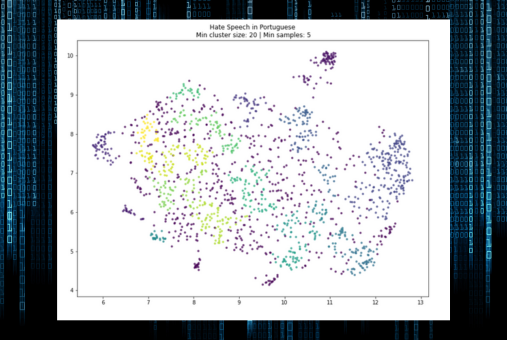

"Attack Detector”, ao contrário, é baseado em modelos multilíngues de código aberto, como o RoBERTa, um modelo PLN para análise de sentimento (também chamado de extração de opinião) que identifica o tom emocional por trás de determinado texto, entre outros.

"Usamos a análise de sentimento para verificar a similaridade ou proximidade das palavras para entender se elas refletem o mesmo sentimento. Em nosso caso, procuramos o ódio. Com isso, podemos 'agrupar', separar grandes blocos de posts", explicou Chaves. "Em nosso caso, é para isso que usamos este agrupamento, para ter esses graus de possibilidade de ódio.”

Antes de treinar os modelos da PLN, a equipe realizou pesquisas sobre quais perfis de jornalistas e ativistas foram mais atacados nas redes sociais, as palavras mais usadas em tais ataques e os tipos mais frequentes de perpetradores, entre outros critérios. Para isso, entrevistaram especialistas e organizações que acompanham de perto a violência online contra membros da imprensa, como Artículo 19, no caso do México.

Ao rastrear esses perfis, eles selecionaram uma amostra de tuítes dirigidos a jornalistas e ativistas frequentemente atacados e etiquetaram manualmente aqueles que preenchiam as características dos ataques com discursos de ódio. Com essas informações eles treinaram os modelos PLN, automatizando a análise e depois otimizando-a.

Com os dados obtidos por meio do modelo e metadados como dados do usuário, data, hora e localização geográfica dos tuítes, é possível analisar, por exemplo, como surge o fluxo de divulgação desses ataques, a interação entre usuários e tuítes, e se já existem comunidades estabelecidas para a criação e divulgação de tais ataques.

"Podemos também descobrir a que horas do dia [os ataques] tendem a acontecer, pois se pudermos identificar isso, talvez possamos vinculá-lo ao contexto do que está acontecendo no país. Portanto, talvez se um certo evento político ou algum evento acontecer, possamos saber que é o que pode estar desencadeando esse ataque", disse Aguirre, que também fez parte da equipe que desenvolveu o "Monitor do Discurso Político Misógino".

O desenvolvimento do “Attack Detector” começou em junho de 2022 e levou cerca de seis meses. Foi somente em novembro daquele ano que o modelo entrou numa fase piloto, onde foi lançado para monitorar contas selecionadas no Twitter.

Desde então, a equipe continua trabalhando na otimização do funcionamento da ferramenta e está trabalhando para torná-la cada vez mais capaz de identificar não apenas ataques com palavras ofensivas específicas, mas também ataques com construções menos literais, tais como aquelas que incluem ironia, insultos disfarçados ou ataques à credibilidade de um jornalista, por exemplo.

"Você também tem que lidar com frases que parecem ataques, mas são ironias e não há computador que consiga detectar com certeza quando é ironia ou quando é um ataque com discurso de ódio. Isto só pode ser feito por um ser humano que compreenda, por exemplo, a realidade do México ou do Brasil", disse Chaves. "Hoje detectamos estes casos de ironia, mas eles são classificados como ataques. Para que sejam classificados como ironia, temos que melhorar nosso banco de dados de treinamento, que é uma das prioridades e objetivos para este ano".

Fernanda Aguirre e Gibrán Mena, de Data Crítica (México); e Reinaldo Chaves e Schirlei Alves, da Abraji (Brasil). (Foto: JournalismAI)

A equipe de “Attack Detector” hospedou tudo sobre o modelo no GitHub, e está disponibilizando um site onde o banco de dados da ferramenta e uma série de visualizações de dados com resultados de monitoramento podem ser baixados. Algumas dessas visualizações mostram os usuários com o maior número de ataques, os usuários que iniciam mais ataques e os jornalistas e ativistas mais atacados, tanto no México como no Brasil.

Embora o programa JournalismAI Fellowship tenha terminado em dezembro passado, Abraji e Data Crítica planejam continuar trabalhando juntos no treinamento de “Attack Detector” com recursos de ambas as organizações. O próximo passo, disseram eles, é o desenvolvimento de uma API (interface de programação de aplicativos) para que outras organizações possam fazer uso do modelo para monitorar o discurso de ódio online em outras áreas. A equipe espera que o API esteja pronto no final deste ano.

"Queremos deixar a porta aberta para que outras organizações a utilizem através do API", disse Aguirre. "Por exemplo, em um período eleitoral no México, se houver uma organização que monitore a violência política, uma vez que o modelo detecta a linguagem sexista, ele pode ser aplicado a muitas outras coisas, como o monitoramento de candidatas para essas eleições ou de defensoras da terra, exclusivamente. Acho que pode ser usado de forma bastante ampla e pode ser adaptado a diferentes tipos de pesquisa.

O uso da inteligência artificial no jornalismo é sempre acompanhado de dilemas éticos, e as ferramentas da PLN não são exceção. Ciente disso, a equipe de “Attack Detector” garantiu que seu modelo tivesse sempre algum nível de supervisão humana.

Durante seu treinamento para detectar discurso do ódio, a ferramenta foi constantemente auditada para avaliar quão bem ela estava fazendo seu trabalho, com verificação manual de seus resultados.

"Não é um processo totalmente automatizado, porque sempre há presença humana em maior ou menor grau, mesmo que seja simplesmente para avaliar e dizer que a rotulagem estava correta, mas não deixamos que seja algo que seja decidido apenas pelo algoritmo", explicou Aguirre.

Quando o modelo se depara com um texto em que o discurso de ódio não é tão óbvio ou quando está disfarçado, a equipe intervém para fazer uma segunda avaliação. De acordo com os desenvolvedores do “Attack Detector”, os modelos PLN nem sempre seguem um padrão definido, e seus resultados não consideram fatores contextuais.

“Attack Detector” está baseado en modelos multilíngues de código aberto para análise de sentimento, que identificam o tom emocional por trás de determinado texto. (Foto: "Attack Detector")

"É difícil classificar realmente só através de um robô e não ter a a parte humana ali de compreender o que está acontecendo na avalanche de ataques", disse Alves, jornalista de dados especializada em direitos humanos e a outra representante da Abraji na equipe, à LJR. “Ajuda nesse esforço de [manejar] um grande volume de informação, mas também precisa ter alguém ali para fazer o ajuste final, digamos assim. Acho que sempre tem que ter esse olhar humano para conseguir também fazer essa última classificação, de olhar o que realmente é e o que não é [um ataque com discurso de ódio]".

Como os fenômenos sociais que eles analisam, modelos informáticos como o “Attack Detector” evoluem e mudam com o tempo e, portanto, devem passar por constante manutenção e atualização dos bancos de dados em que funcionam. Os representantes da Abraji e da Data Crítica planejam continuar testando novos modelos PLN e análises linguísticas para melhorar a precisão e o desempenho da ferramenta.

A equipe espera num futuro próximo formar parcerias com outras organizações de liberdade de expressão, tanto no Brasil como no México, bem como em outros países. Eles antecipam que o modelo poderia ter uma aplicação prática no entendimento e combate à violência digital contra jornalistas e que as capacidades do “Attack Detector” poderiam ser expandidas para incluir não apenas o conteúdo do Twitter, mas também outras plataformas onde existe violência com discurso de ódio, como Facebook, Instagram e TikTok.

"Temos notado que existe violência digital, lamentavelmente e com bastante frequência contra jornalistas e defensores do meio ambiente, no Facebook", disse o cofundador do Data Crítica Mena à LJR. "Estamos buscando amplas parcerias e financiamento para expandir os esforços, primeiro no desenvolvimento de análises de outras plataformas, como o Facebook, e depois na criação de estratégias de impacto onde possamos fazer com que uma ferramenta como esta tenha um claro impacto na diminuição da violência digital contra jornalistas.”

A segunda edição da JournalismAI Fellowship acontecerá este ano e as inscrições estão abertas para aqueles que desejam desenvolver novos projetos que liguem o uso da inteligência artificial ao jornalismo.

A JournalismAI está convidando jornalistas e profissionais técnicos de meios de comunicação de todo o mundo para participar do programa, que é gratuito e acontece inteiramente online.

"Ao contrário de outros programas, a JournalismAI Fellowship não selecionará bolsistas individuais, mas um máximo de 15 pares de bolsistas serão selecionados para participar da classe de 2023. Estes pares formarão equipes com as quais trabalharão por seis meses para criar soluções baseadas na IA que melhorem o exercício do jornalismo", disse Lakshmi Sivadas, gerente do programa, à LJR.

A JournalismAI Fellowship será realizada entre junho e dezembro de 2023 e os selecionados deverão dedicar pelo menos oito horas por semana ao desenvolvimento de seus projetos. Cada equipe receberá apoio financeiro, assim como orientação e treinamento de especialistas no uso da inteligência artificial no jornalismo.

O prazo final para as candidaturas é 21 de abril.